Para facilitar o entendimento, sugiro como leitura prévia 2 textos anteriores em que abordo este mesmo tema. O primeiro, a respeito do “Estudo de 100 anos para a Inteligência Artificial” e o segundo, referente à definição do que é IA.

Nos últimos 15 anos, IA conseguiu cumprir a sua expectativa histórica de permear a vida do ser-humano. É verdade que um dos grandes responsáveis por isto são os “pequenos” equipamentos que carregamos em nossos bolsos e bolsas diariamente, os smartphones. De todo modo, ao se tornar uma força central em nossa sociedade, a própria IA vem se modificando. O grande objetivo das mentes por trás do seu desenvolvimento, não é mais construir sistemas que são inteligentes, mas construir sistemas inteligentes que são confiáveis e focados no ser-humano.

Pode parecer um simples “jogo de palavras”, mas a realidade é que esta visão traz uma mudança profunda no direcionamento das pesquisas no campo da IA. Para resumir este direcionamento, usarei apenas um termo: dados. Quem tem familiaridade com a hierarquia DIKW percebe imediatamente o que isto quer dizer. Dados são a base em que se constrói o conhecimento. Ao focar neles, as pesquisas em Inteligência Artificial se aproximam cada vez mais do que transforma o ser-humano em ser-humano, a alta capacidade de aprendizagem – de transformar conhecimento em sabedoria.

Não é de se estranhar, portanto, que uma das áreas da IA que mais cresce é a de machine learning. O aprendizado de máquinas vem se desenvolvendo enormemente com o suporte dos recursos de computação em nuvem e com a coleta generalizada de dados baseados na web. Este ambiente também vem sendo impulsionado pelo deep learning, utilizado para treinar (sim, o termo é o mesmo usado em referência ao ser-humano) redes neurais convolucionais (uma forma de rede neural artificial adaptativa). Trocando em miúdos, pode ser resumido como um modo de ensinar máquinas usando o modelo de redes neurais.

Bom, o resultado disto foi um salto na performance de algoritmos de processamento de informação (vale lembrar que informação significa dado contextualizado), acompanhado de outro salto significativo em tecnologia de detecção, percepção e reconhecimento de objetos. Aliados a plataformas e mercados impulsionados por dados, este ambiente estimulou a concentração de pesquisas em algumas áreas específicas da IA.

Aprendizado de máquinas em grande escala (large-scale machine learning): um dos maiores desafios em termos de machine learning atualmente é aumentar a extensão de algoritmos existentes para possibilitar que trabalhem com banco de dados extremamente grandes (o chamado big data). Em banco de dados tradicionais, um algoritmo de aprendizado de máquinas pode se dar o “luxo” de checar várias vezes o mesmo conjunto de dados (afinal, para os padrões das máquinas não são extensos –possuem “apenas” alguns milhões de linhas). Quando se trata de big data, a coisa muda de figura, não se pode repetir este padrão com bilhões e bilhões de linhas de dados – um processador atual poderia “travar” realizando uma ação destas. A solução é otimizar métodos que permitam processar apenas uma vez os dados ou que os dividam em conjuntos. É por este caminho que segue esta tendência de estudo (para aqueles que possuem conhecimentos em modelagem matemática ou estatística, fiquem de “olho” nesta área).

Deep Learning: sei que parece título de filme B, mas penso que vale a pena dar uma explicação um pouco mais técnica aqui do que na “palhinha” de algumas linhas acima. É chamado de aprendizado profundo, a habilidade de se treinar com sucesso redes neurais convolucionais (em teoria da informação, convolucional é um tipo de código para detecção de erros). Em machine learning, a rede neural convolucional funciona de maneira inspirada no córtex visual dos animais, reconhecendo largura e altura de um volume e se ativando quando “vê” algo similar em uma determinada posição espacial. Um dos campos que mais se beneficiam disto é o da visão computacional, que pode ser aplicada em reconhecimento de objetos (e atividades gerais de reconhecimento) e áreas de percepção artificial como voz e linguagem natural (os idiomas que falamos). Sei que a maioria não ligará “o nome à pessoa”, mas saibam que coisas comuns que usamos – como os filtros para fotos de aplicativos como Instagram – se beneficiam destes conhecimentos.

Aprendizado por reforço (reinforcement learning): não sei quantos dos que me leem tiveram a experiência de terem “aulas de reforço” no colégio. Lembro do drama que era para mim chegar duas horas antes das aulas às quintas-feiras, para ter aula de reforço em português. O objetivo deste tipo de aula era, no meu caso, utilizar a língua portuguesa em situações práticas reais (escrever cartas, interpretar textos e entender suas implicações). Funciona de modo similar no caso das máquinas, envolve ensiná-las a aprender algo necessário para executar ações no mundo real. O modo de se fazer isto é através de estruturas sequenciais para tomada de decisão baseada em experiência. Este campo, estagnado há décadas, tomou um impulso com o surgimento do deep learning. Um exemplo prático é o AlphaGo, desenvolvido pela Google, para ensinar máquinas a jogar o jogo chinês Go (para mais detalhes tanto de um quanto de outro, incluí links que direcionam ao site do AlphaGo e à explicação do jogo original na Wikipédia). O AlphaGo foi treinado inicialmente através de um banco de dados criado por especialistas humanos no jogo e posteriormente, via aprendizado por reforço, praticando através de jogos contra si mesmo. A aplicação desta área é bem dinâmica, atua desde viagens espaciais até extração de petróleo em grandes profundezas (como no caso do nosso pré-sal).

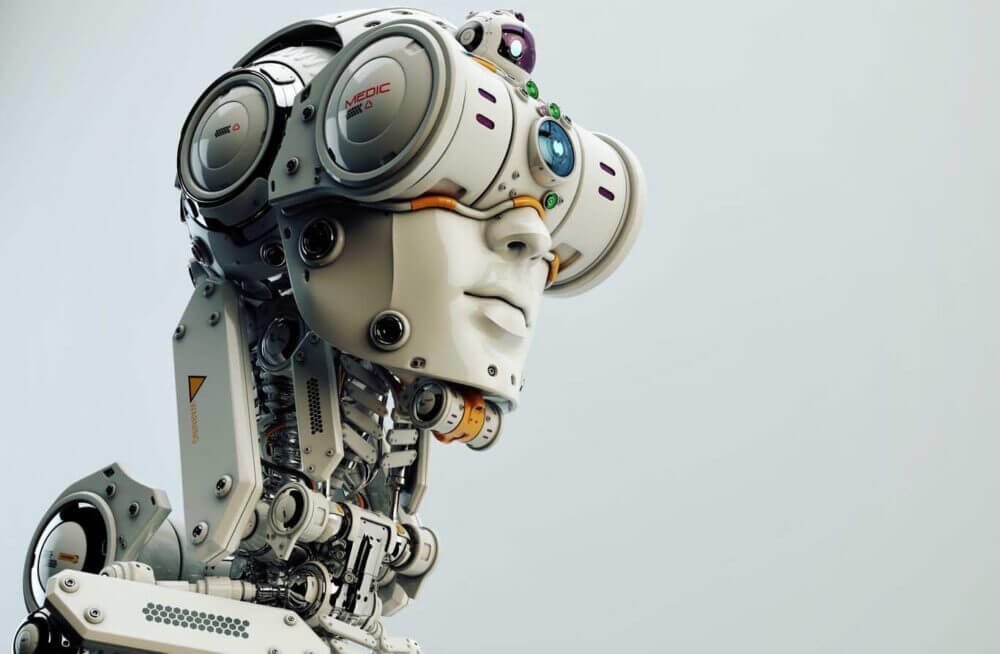

Robótica: os esforços atuais se concentram em treinar os robôs a interagirem com o mundo a sua volta de maneira geral e previsível. Um dos caminhos é utilizar deep learning e aprendizado por reforço para ajudá-los a explorar o ambiente e “rodar” sua programação sem espaço para cometer erros que possam ser prejudiciais para seus sistemas e para os que estiverem à volta. Este é o problema, por exemplo, dos carros automáticos – aqueles que se dirigem sozinhos e que já estão sendo testados. O desafio é aumentar a percepção da máquina, incluindo sua “visão”, “força” e sensibilidade “tátil”.

Visão computacional: esta é a forma mais proeminente de percepção da máquina hoje. É uma das áreas de IA que teve a sua evolução impulsionada pelo aparecimento do deep learning. Pela primeira vez, os computadores são capazes de executar algumas tarefas de classificação visual melhor do que as pessoas. Combinada com computação gráfica, tem sido a responsável pela “explosão” da tendência de realidade aumentada.

Processamento de linguagem natural: muitas vezes usado em conjunto com o reconhecimento automático de voz, o processamento de linguagem natural é outra forte tendência da área de percepção da máquina. 20% das consultas ao Google já são feitas por voz e alguns testes já mostram a possibilidade real de usá-lo para tradução em tempo real. O foco dos estudos está se concentrando cada vez mais no desenvolvimento de sistemas capazes de interagir com as pessoas por meio do diálogo (e não simplesmente reagir a comandos digitados).

Internet das Coisas: também conhecida pela sigla IoT (Internet of Things), é um dos grandes focos de pesquisas na área de Inteligência Artificial. Está relacionada à ideia de que uma grande quantidade de dispositivos (ou coisas) podem ser interconectados para coletar e compartilhar seus dados sensoriais (eletrodomésticos, veículos, edifícios, máquinas fotográficas e roupas são alguns exemplos). Embora seja uma questão que envolva em grande parte a criação de tecnologia e a utilização de rede sem fio para conectar os dispositivos, há um enorme desafio no processamento e uso inteligente destas imensas quantidades de dados (a serem) gerados que ainda precisa ser equacionado. Outro ponto, é que atualmente esses dispositivos utilizam uma quantidade grande de protocolos de comunicação incompatíveis. IA está sendo utilizada tanto para desenvolver soluções para lidar com esta possibilidade exponencial de big data quanto para ajudar a domar a “Torre de Babel”.

Há ainda outras tendências que de tão específicas, prefiro não abordar – como computação neuromórfica (neuromorphic computing), criação de algoritmos baseados na teoria dos jogos, sistemas colaborativos, dentre outros. O que une estas tendências não citadas e as demais que comentei é a sua característica human-aware (centrada no ser-humano – como mencionado no início do texto). Isto quer dizer que por mais complicado que possa parecer, todas estas iniciativas são especificamente modeladas e desenvolvidas com o foco nas pessoas que se espera que elas interajam. Por enquanto não há o risco de se criar algo como o sistema Skynet – do Exterminador do Futuro. O maior risco trazido pelo deep learning para o aprendizado da máquina, é o processo conhecido como overfitting. Assim como nós, seres-humanos, as máquinas também apreciam a boa e velha decoreba. Quando percebem que uma resposta não muda, elas simplesmente a decoram. O overfitting ocorre quando tentam generalizar algo que é específico, usando o que decoraram. Como se pode ver, o que faz a diferença em qualquer aprendizado é o contexto.