Sobre quando teremos uma IA de nível humano

Probabilidade de 10% até 2031, de 50% até 2052 e de quase 80% até 2100.

O Open Philanthropy Project (“Open Phil”) é uma fundação interessada em financiar estudos de segurança em IA. Possui cerca de US$ 20 bilhões disponíveis para identificar oportunidades, financiar, acompanhar os resultados e publicar as descobertas. Em 2020, pediu à sua pesquisadora sênior Ajeya Cotra que produzisse um relatório preditivo que pudesse estimar quando a IA atingiria níveis humanos. Ajeya compartilhou comigo um Google Drive com o seu relatório e os modelos usados para a predição e gentilmente permitiu que divulgasse o material. Criei uma pasta compartilhada no meu próprio Drive com os relatórios, que pode ser acessada aqui. Apesar de ser um documento informal (é dividido em 4 arquivos e tem ao todo 170 páginas), é possível perceber pela quantidade de citações na comunidade de desenvolvimento de IA, que está sendo usado como uma espécie de bússola (ou farol, que aponta ao mesmo tempo para onde ir e não ir).

O relatório encontrou uma probabilidade de 10% de termos uma “IA transformadora” (uma IA que produza uma transição tão impressionante quanto a Revolução Industrial – muito provavelmente isso exigiria que fosse tão inteligente quanto os seres humanos) até 2031, uma probabilidade de 50% disto acontecer até 2052 e uma probabilidade de quase 80% até 2100. Apesar de alguns não concordarem com as premissas e os resultados, como o Eliezer Yudkowksy (falei dele no texto sobre o segundo relatório da AI100), o Relatório Cotra vem gerando um pequeno mercado dedicado à sua sumarização e tradução para o público leigo. Posso citar os esforços do CEO da própria Open Phil, o Holden Karnofsky, que publicou um texto sobre o método das âncoras biológicas e o sumário feito pelo editor da Alignment Newsletter, Rohin Shah. Me baseio tanto nos escritos deles quanto no trabalho da Ajeya para produzir essas linhas.

Vamos em frente, como já citei o Relatório Cotra tenta prever quando teremos a primeira “IA transformadora”. Este é um dos termos usados para qualificar o que é chamado academicamente de AGI (Artificial General Intelligence – Inteligência Geral Artificial). O relatório se baseia nas seguintes premissas:

- Estimativa da quantidade de computação inferencial que o cérebro humano faz;

- Estimativa do custo de treinamento, em termos computacionais, necessário para obter uma rede neural que faça a mesma quantidade de computação inferencial;

- Ajuste do “progresso algorítmico” (prevendo que no futuro as redes neurais serão cada vez melhores no uso eficiente dos recursos computacionais);

- Cálculo da quantidade de dinheiro necessário para financiar o treinamento da IA;

- Estimativa do ano em que isso acontecerá (surgimento da primeira AGI).

É claro que essas premissas levam em consideração algumas suposições questionáveis. Por exemplo, a AGI pode advir de um ecossistema de projetos interativos (assim como a Revolução Industrial veio de um ecossistema de tecnologias interativas), de modo que não seria necessário treinar uma IA do tamanho de um cérebro de uma só vez. Ajeya acha que o cenário da Revolução Industrial é mais provável do que o cenário da execução única, mas considera mais apropriado trabalhar com a hipótese do cenário de execução única porque ele pode ser visto como uma amplitude de intervalo útil. Aqui vale uma explicação adicional, em estatística descritiva existe o conceito de limite de classe, que são os valores que definem cada um dos grupos de valores em que se subdivide os dados observados (esses grupos são chamados de classes). São conhecidos como limite superior (LS) e limite inferior (LI) da classe. A amplitude do intervalo de classe, por sua vez, é a diferença entre os seus limites superior e inferior. Para podermos entender qual é a amplitude do intervalo das estimativas da hipótese que o Relatório Cotra traz (o cenário de execução única), vejamos cada premissa uma a uma.

Quanta computação o cérebro humano é capaz de fazer?

Estimar quanta computação o cérebro humano faz é uma tarefa ingrata. Qual parâmetro usar? Para ser justo, é preciso que o parâmetro possa ser comparado em termos computacionais (de preferência uma métrica conhecida). Uma unidade básica de computação, usada para determinar o desempenho de computadores digitais, é o FLOPS ( FLoating-point Operations Per Second – operações de ponto flutuante por segundo). Como já é usada para medir o desempenho computacional dos nossos computadores, parece ser uma solução adequada usar a mesma métrica e medir o desempenho computacional do cérebro em FLOPS. Mas, qual seria a capacidade do nosso cérebro em operações de ponto flutuante por segundo? Felizmente, outro analista do Open Phil, Joe Carlsmith, publicou um relatório sobre o assunto alguns meses antes do Relatório Cotra. Aqui vale reforçar que esse tipo de publicação feita pela Open Phil é chamada de white paper (em português, livro branco). Um white paper não é uma publicação acadêmica ou científica (não passa pelo processo de revisão cega por pares), se assemelha mais a um relatório técnico. Mas, como outros tipos de literatura Grey, possui a vantagem da rapidez (e em um ambiente competitivo como o desenvolvimento tecnológico, isso pode fazer a diferença).

Carlsmith [1] concluiu que o cérebro usa entre 10¹³ e 10¹⁷ FLOPS. De onde saiu esse número? Resumidamente, o autor fez uma revisão de literatura e esse foi um número recorrente dado pela maioria dos especialistas. Ele vem do fato de que existem cerca de 10¹⁵ sinapses no cérebro, cada uma atingindo o pico sináptico cerca de uma vez por segundo. O pico sináptico, por sua vez, é estimado em um FLOP. Não ficou claro no texto se ele levou em conta pesquisas recentes a respeito da computação dendrítica (a computação que acontece dentro dos dendritos – veja a seção 2.1.2.2 do relatório [1]), uma vez que taxas de picos dendríticos são de 5 a 10x maiores do que as taxas de picos somáticos. De qualquer forma, estou considerando que ele forneceu uma faixa suficientemente ampla.

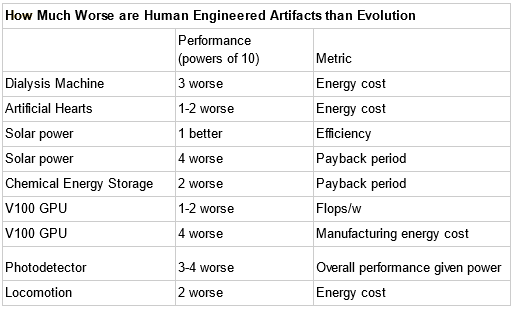

Pelo trabalho do Carlsmith [1] não fica claro se uma IA de nível humano também precisaria fazer 10¹⁵ operações de ponto flutuante por segundo, mas sabemos que os computadores podem funcionar com algoritmos mais ou menos eficientes; de forma que não seria incoerente considerar que as redes neurais também poderiam usar sua computação de forma mais ou menos eficiente do que o cérebro. Um outro relatório, feito pelo pesquisador Paul Christiano, mostra que vários processos biológicos ainda estão muito além da tecnologia humana (Fig. 1). Christiano é o noivo da Ajeya e, gentilmente, também permitiu que compartilhasse o material (está no mesmo Drive criado para o Relatório Cotra).

Ajeya combina o trabalho de Carlsmith [1] com outra métrica usada pela Open Phil, em que eles veem como as IAs existentes se comparam a animais com capacidade computacional aparentemente semelhante; por exemplo, dizem que o AlphaStar da DeepMind (IA que joga Starcraft) tem tanta computação inferencial quanto uma abelha e parece “subjetivamente impressionante” (não tenho ideia do que o termo significa, subjetivamente impressionante em ganhar jogos online multiplayer? Picar pessoas?). De qualquer forma, decidiram penalizar a IA em uma ordem de magnitude, em comparação com a Natureza. Uma IA de nível humano precisaria então fazer 10¹⁶ operações de ponto flutuante por segundo, segundo a Open Phil.

Quanta computação seria necessária para se treinar um modelo que fizesse 10¹⁶ operações de ponto flutuante por segundo?

No paradigma atual do machine learning (ML), para termos um produto robusto de IA que rode bem em computadores médios, como os desktops ou notebooks atuais, é preciso treinar o modelo em computadores com enorme capacidade de processamento. Para efeito de comparação, o GPT-3 foi treinado no supercomputador NVIDIA V100 da Microsoft, localizado no data center da Azure. Segundo um post da própria Microsoft, a configuração da máquina tinha mais de 285.000 núcleos de CPUs, 10.000 GPUs e 400 gigabits por segundo de conectividade de rede para cada servidor de GPU. Traduzindo os termos técnicos, CPUs são os processadores do seu HD e GPUs são os processadores da sua placa de vídeo (GPUs são bem mais potentes do que CPUs, geralmente configuramos a placa de vídeo para fazer o treinamento dos modelos de ML). Alguns cálculos brutos estimam um custo de treinamento de pelo menos US$ 4,6 milhões, sem incluir os custos de pesquisa e desenvolvimento [2]. Com estes, o valor se elevaria para um número entre US$ 10 e 30 milhões [2]. Voltaremos à questão do custo financeiro mais a frente no texto.

A questão é que se o GPT-3 fosse treinado em um computador de uso normal, levaria no mínimo algumas centenas de anos. Agora, imagine um modelo de 10¹⁶ FLOPS. Não há uma maneira direta de converter requisitos de inferência (os 10¹⁶ FLOPS) em requisitos de treinamento. Ajeya assume que cada parâmetro de treinamento contribui com cerca de 10 FLOPs, o que significaria que o modelo teria por volta de 10¹⁵ parâmetros, contados em unidades de bytes (o GPT-3 tem mais ou menos 10¹¹ parâmetros [2]). Por fim, ela usa algumas leis de escala empírica, derivadas da análise de projetos de ML anteriores para estimar que o treinamento de 10¹⁵ parâmetros exigiria H x 10³⁰ FLOPS de desempenho computacional, o “H” usado na multiplicação representa o “horizonte” do modelo.

“Horizonte” é um conceito de aprendizado por reforço que caracteriza o tempo que a máquina leva para aprender a calcular a recompensa que recebe por algo. Imagine que você foi a um cassino para jogar nas máquinas caça-níqueis, se por acaso acertar de primeira e a máquina começar a jorrar um monte de moedas, como nos filmes, o seu horizonte é de um segundo. Caso você esteja começando uma empresa, o horizonte pode ser de dez anos. Mas, qual seria o horizonte de uma IA de nível humano? Provavelmente a resposta depende de qual tarefa de nível humano desejamos que a IA faça. A variável relativa a quão bem uma IA pode aprender a fazer essa tarefa, também deveria ser considerada. Ajeya reconhece não ter uma boa resposta para a questão e considera três modelos: horizontes de alguns minutos, algumas horas e alguns anos. Ela aborda os critérios no terceiro documento do relatório. Como adicionou outras três ordens de magnitude a cada aumento de horizonte, fechou as três estimativas em curta – 10³⁰ (horizonte de minutos), média – 10³³ (horizonte de horas) e longa – 10³⁶ FLOPS (horizonte de anos).

Para efeito de comparação, existe um supercomputador no Japão, chamado Fugaku, capaz de fazer 10¹⁷ operações de ponto flutuante por segundo. O Fugaku levaria, no limite inferior (10³⁰), cerca de 300.000 anos para completar o treinamento e no limite superior (10³⁶), cerca de 300 bilhões de anos.

É preciso ter em mente que todos esses cálculos foram feitos na base da suposição. Poderíamos até dizer que é um empilhamento de suposições, umas sobre as outras. Por isso, Ajeya tenta ainda outros três métodos para definir o quão difícil seria essa tarefa de treinamento.

O primeiro foi considerar nós, seres humanos, como IAs de nível humano. De quanto treinamento precisamos? A ideia aqui foi comparar nossa infância e adolescência com o período de treinamento de uma IA. Recebemos um fluxo de dados pelos sentidos. Começamos batendo “cabeça” meio aleatoriamente. Parte do que fazemos é recompensado, parte é punido. Eventualmente, nosso comportamento se torna mais sofisticado. Confesso que esse critério me recordou uma passagem do filme Rent, adaptação do musical da Broadway. Uma das canções, Seasons of Love, pergunta “como você mede a vida de uma mulher ou de um homem?”. A resposta é algo como “em luz do dia, em pôr do sol, em meias-noites, em xícaras de café; em polegadas, em milhas, em risadas, em conflitos”, aparentemente agora também em operações de ponto flutuante por segundo, no caso cerca de 10²⁴ FLOPS.

A conta feita é até trivial. Os 10¹⁵ FLOPS do cérebro humano foram multiplicados pelos cerca de 10⁹ segundos da infância e adolescência, por volta de 18 anos (lembram da multiplicação de potências de mesma base? Repete-se a base e somam-se os expoentes). Essa nova estimativa de 10²⁴ certamente é bem menor do que a estimativa de rede neural de 10³⁰ a 10³⁶ de alguns parágrafos acima, mas de nenhuma maneira mais tranquila. A verdade é que nós, seres humanos, não somos páginas em branco. Não começamos do zero e usamos a infância para treinarmos nosso comportamento. A própria estrutura do cérebro codifica certas suposições sobre os tipos de dados que devemos procurar e como devemos usá-los. Com isso, nossos dados de treinamento não são apenas o que observamos durante a infância e adolescência, são tudo o que qualquer um dos nossos ancestrais observou durante a evolução.

Dessa forma, o segundo método foi estimar o número de operações de ponto flutuante usadas no processo evolutivo. Ajeya chegou à 10⁴¹. A computação levou em conta a estimativa de tempo passado desde que os animais com neurônios surgiram (cerca de 10¹⁶ segundos), a estimativa do número de criaturas vivas em qualquer ponto do tempo (cerca de 10²⁰), e a estimativa de FLOPS médios por criatura (cerca de 10⁵). Com estes dois últimos, se calcularia a quantidade total de computação ocorrida em um determinado ponto no tempo. Para mais detalhes, sugiro a leitura da seção “Evolution Anchor hypothesis”, do terceiro documento do relatório (p.25). Reconheço que não é possível dizer o quão exato é esse tipo de estimativa, mas a realidade é que já é um grande feito definir um ponto de partida, mesmo que imperfeito.

O terceiro método foi considerar cada bit de informação no genoma como um “parâmetro” de treinamento. Com isso, seria possível definir a quantidade de parâmetros presentes nos humanos e como o número afeta o tempo de treinamento. Chegou-se a 7,5 x 10⁸ parâmetros (ver p.18-21 do terceiro documento). Penalizando com base no horizonte de anos (ver p.17 do mesmo documento – long horizon), temos a estimativa de 10³³ FLOPS.

Como ajustamos o progresso algorítmico ao modelo?

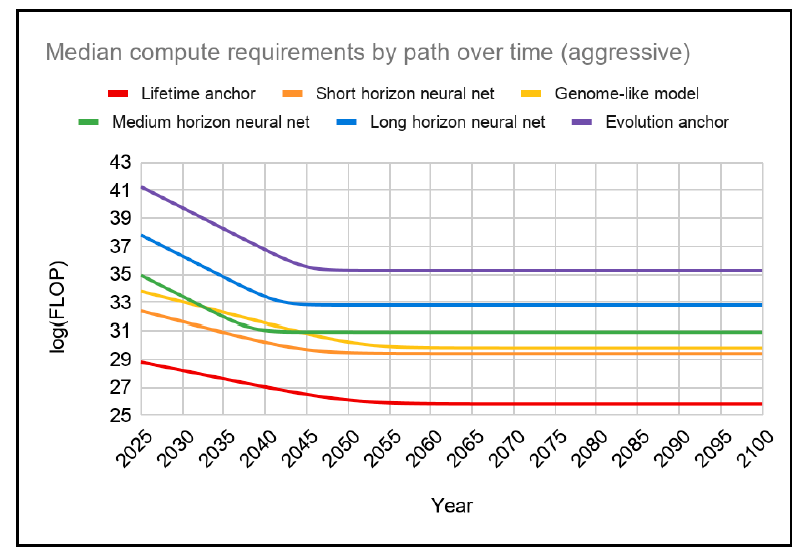

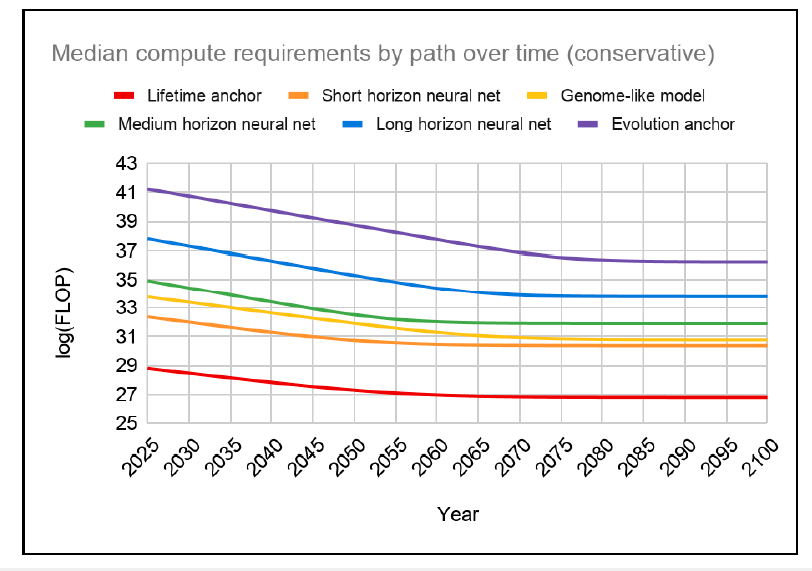

Levando em consideração que na segunda premissa foram levantados cinco custos de treinamento (em termos de computação), que se inicia em 10²⁴ FLOPS, passa pelos horizontes curto (10³⁰), médio (10³³) e longo (10³⁶ FLOPS), e fecha em 10⁴¹ FLOPS, o relatório assume, de maneira geral, o horizonte médio como custo computacional para se treinar uma IA de nível humano. Para fazer o ajuste do progresso algoritmo, Ajeya se baseia fortemente no trabalho [3]. No paper, Hernandez & Brown analisam quantos FLOPS foram necessários para treinar várias IAs de reconhecimento de imagem, em um nível equivalente de desempenho, entre os anos de 2012 e 2019. Os autores descobriram que, nesses sete anos, houve uma diminuição de custo computacional na ordem de 44x. Isso quer dizer que a eficiência do treinamento dobra a cada dezesseis meses.

O Relatório Cotra assume um tempo de duplicação um pouco maior do que o levantado em [3], porque é mais fácil progredir em campos mais evoluídos, como reconhecimento de imagem, do que na nova tarefa de se desenvolver uma IA de nível humano. Ela escolhe um tempo de duplicação de dois a três anos. Com isso, é possível estimar que se a eficiência de treinamento dobra a cada 2-3 anos, ela se decuplicaria (cresceria 10x) a cada década ou década e meia. Portanto, embora se possa gastar 10³³ FLOPS para treinar uma IA de nível humano em 2022, em dez ou quinze anos, pode-se gastar 10³², em 20 ou 30 anos 10³¹, em 30 ou 45 anos 10³⁰ e assim por diante. Isto nos leva diretamente à quarta premissa.

Qual é a quantidade de dinheiro que se precisaria gastar para podermos treinar uma IA de nível humano?

Se você quiser treinar um modelo de IA verdadeiramente robusto (nível GPT-3), é possível alugar recursos computacionais em um supercomputador como o Fugaku. Atualmente, é necessário solicitar acesso ao Consórcio que administra a estrutura, mas já está em desenvolvimento uma API, a Fugaku Cloud Platform (FCP), que democratizará o acesso e o custo. O valor inicial é estimado em cerca de US$ 1 por hora para usar 10¹⁷ FLOPS quando a FCP estiver em funcionamento. Com base nestes valores, alugar os 10³³ FLOPS necessários para treinar uma IA de nível humano custaria aproximadamente US$ 10¹⁶ (dez quatrilhões de dólares) no horizonte médio. Para termos uma base de comparação, segundo o relatório da consultoria financeira GOBankingRates, publicado em fevereiro, há cerca de US$ 40 trilhões em dinheiro físico presente no mundo em 2022 [4]. Valor este, que pode chegar a um quatrilhão de dólares se criptomoedas, broad money (M2 e M3), investimentos e derivativos forem adicionados ao total [4]. Isso quer dizer que se literalmente “limparmos o tacho” do mundo, teríamos “só” 10% do valor necessário.

Mas, é sabido que os custos de computação caem rapidamente. Algumas formulações da Lei de Moore sugerem que ela é reduzida pela metade a cada dezoito meses. O número exato é meio controverso uma vez que essa redução tem se desacelerado, ultimamente acontece a cada 3-4 anos. De qualquer forma, é possível considerar que, com o passar do tempo, o progresso algorítmico reduzirá o custo de treinamento em FLOPS e o progresso em hardware reduzirá o custo desses FLOPS em dólares. Assim, o treinamento se tornará gradualmente mais acessível nos próximos anos e décadas. Quando atingir um custo que alguém esteja disposto a pagar, é quase certo que dinheiro para se treinar uma IA de nível humano não será o problema principal.

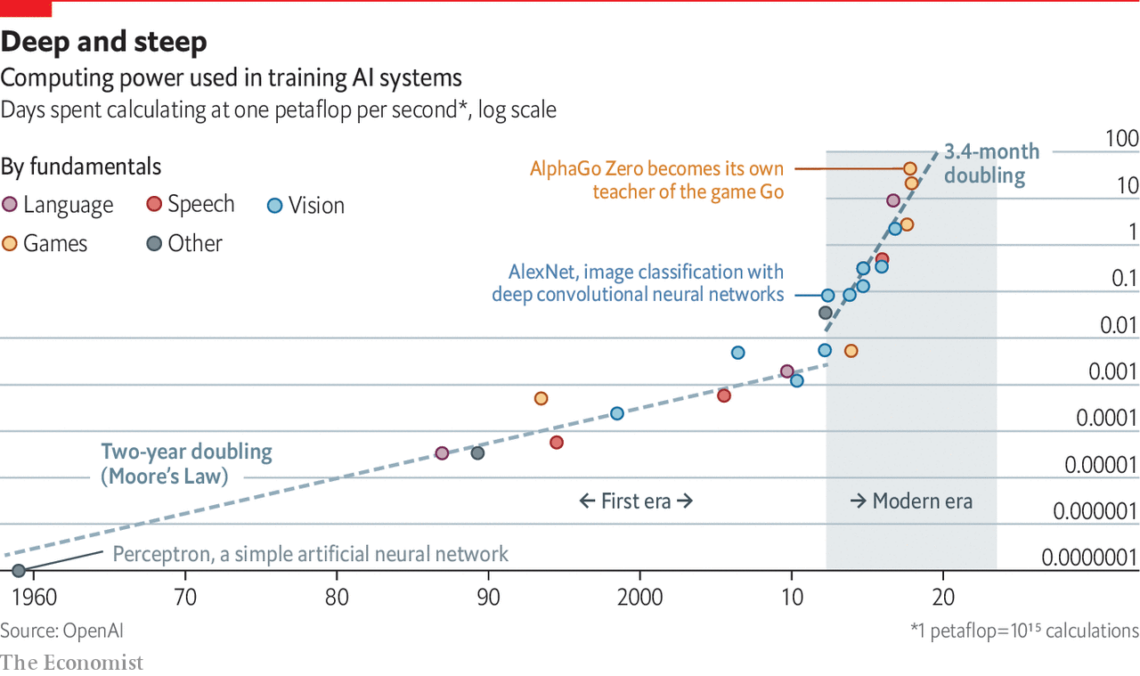

Mas qual é esse custo? Uma reportagem publicada em 2020 pela revista The Economist [5], já alertava para o aumento do custo financeiro causado tanto pela redução da Lei de Moore quanto pelo aumento da complexidade das tarefas e competição entre as empresas. Em alguns países, como nos EUA por exemplo, o ritmo de formação de especialistas em IA caiu devido a uma estratégia próxima à “canibalização”, com Universidades perdendo professores(as) para as empresas de tecnologia e não tendo como repor seu pessoal [6]. Vale lembrar que com menos professores(as), menos alunos(as) são formados(as) .

A Fig. 2 aborda um pouco esse aumento de custo com base na necessidade de petaFLOPS (um quatrilhão de FLOPS ou mil teraFLOPS). Aqui vale explicar que a menção à Lei de Moore no gráfico é meio marota. O autor quis relacioná-la aos dias gastos em treinamento para modelar diferentes tarefas de IA, embora os eixos de comparação sejam série histórica e necessidade de poder computacional. A leitura ali seria que entre os anos de 1960 e 2012 a necessidade de poder computacional (onde o custo financeiro se baseia) dobraria a cada 2 anos. A partir da década de 2020, ela dobraria a cada 3,4 meses.

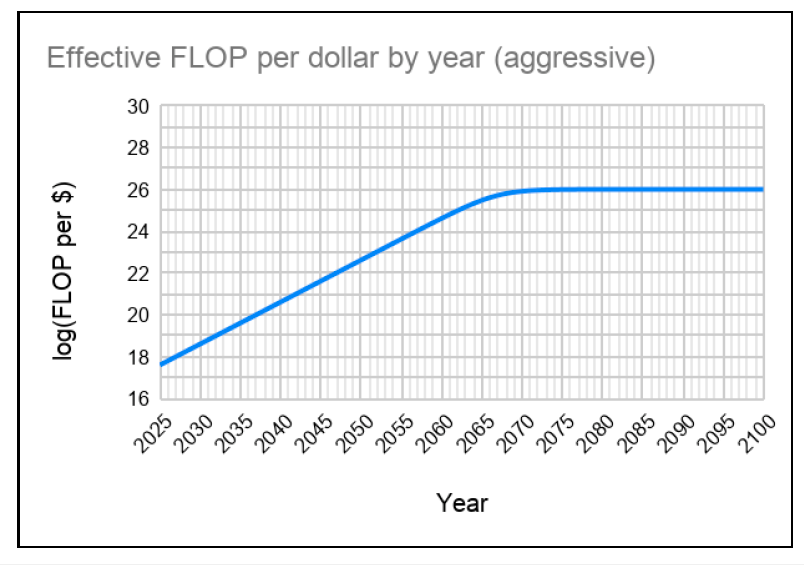

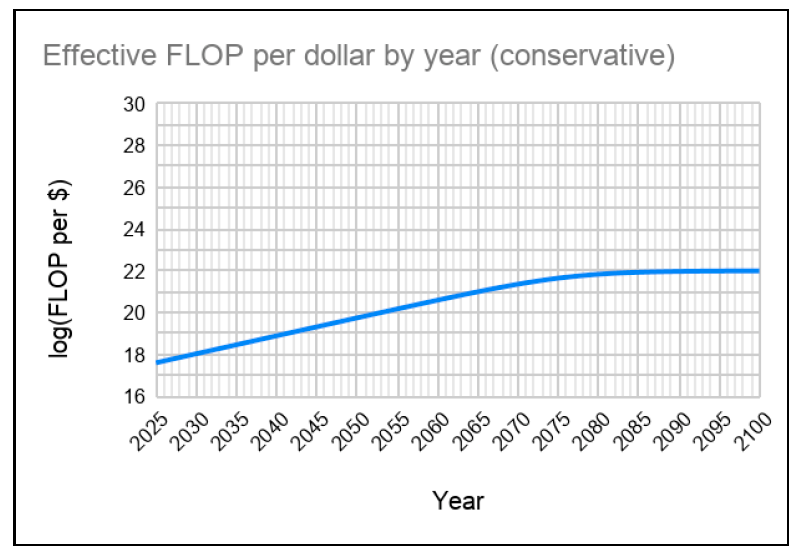

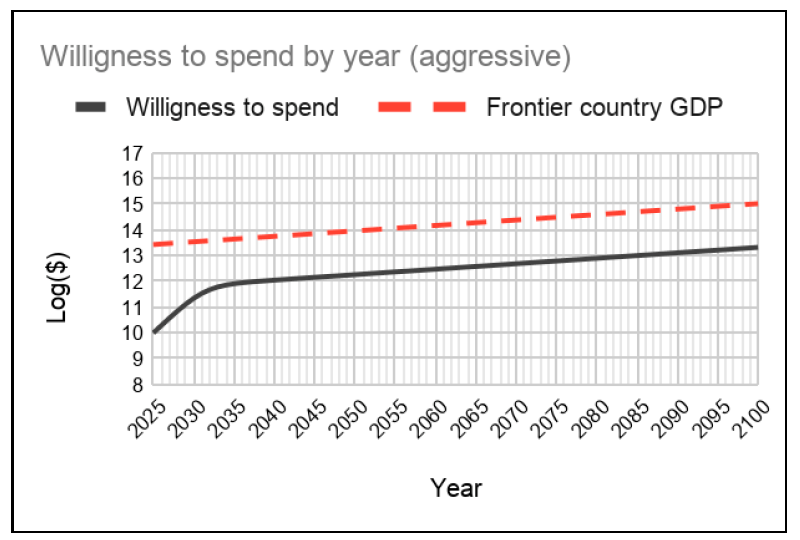

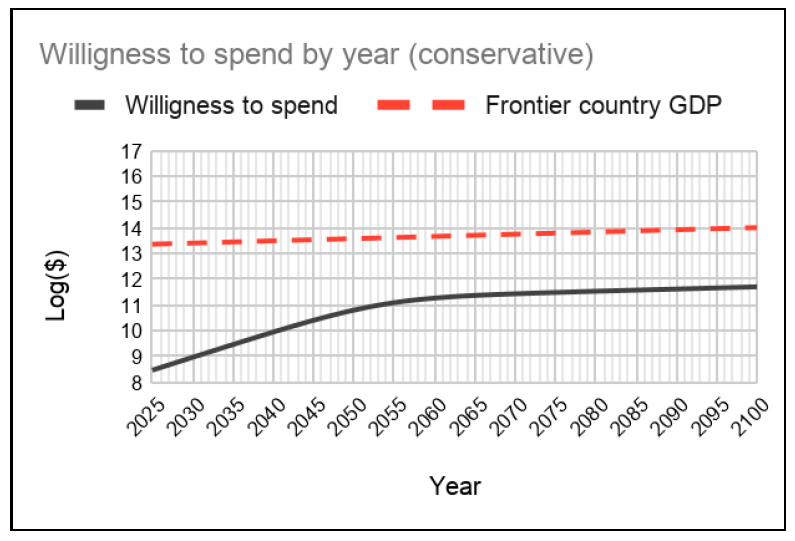

No arquivo 4 do relatório, Ajeya especula a variação do custo de FLOPS por dólar até o final do século (a contar de 2025) e do valor que alguém estaria disposto a gastar para se treinar uma IA de nível humano (Figs. 3 a 6).

Temos o valor de US$ 1 bilhão como base em um escalonamento de curto prazo (2025). Há um aumento em uma ordem de magnitude para US$ 10 bilhões em um cenário agressivo, algo similar a uma bolha, com investidores colocando cada vez mais dinheiro e esperando retorno maiores e uma diminuição para US$ 300 milhões em um cenário conservador. São valores astronômicos de investimento para uma modelagem. Para efeito de comparação, a OpenAI foi fundada com US$ 1 bilhão de capital de risco (sem garantia de retorno), segundo a entrada da Wikipédia sobre o laboratório. Em um escalonamento de médio prazo (2040), os valores são ainda mais astronômicos. Como valor base temos US$ 100 bilhões em 2040. No cenário agressivo, os US$ 100 bilhões são atingidos em 2030 e no cenário conservador em 2055.

Em que medida isso é plausível? No auge do Projeto Manhattan, os EUA estavam investindo cerca de 0,5% de seu PIB no esforço; um investimento semelhante hoje representaria, aproximadamente, os tais US$ 100 bilhões. Ajeya especula que a disposição máxima para se gastar em computação no treinamento de um modelo transformador, como o da IA de nível humano, seria 1% do PIB (com um PIB crescendo a 3% ao ano). Este é o cenário base, levando em consideração países do G7. No cenário agressivo, a disposição máxima seria 2% do PIB (com um PIB crescendo a 5% ao ano) e no cenário conservador, 0,5% do PIB (com um PIB crescendo a 2% ao ano).

Levando em consideração o progresso algorítmico (Figs.7 e 8), podemos ver que a eficiência das computações pode ser a incentivadora da disposição em investir.

Peguemos, por exemplo, os cenários conservadores das Figs 4 e 8. A medida em que a mediana dos requisitos computacionais caem em FLOPS (Fig.8) para uma escala logarítmica de 25 e a variação do custo de FLOPS por dólar se estabiliza (Fig.4) em uma escala logarítmica de 22, é possível imaginar que um dos países do G7 considere que valha a pena investir 0,5% do PIB, com um PIB crescendo a 2% ao ano (sem contar outros países, como a China e a Índia, que também poderiam considerar o investimento). A questão agora recai na quinta e última premissa.

Quando teremos uma IA de nível humano?

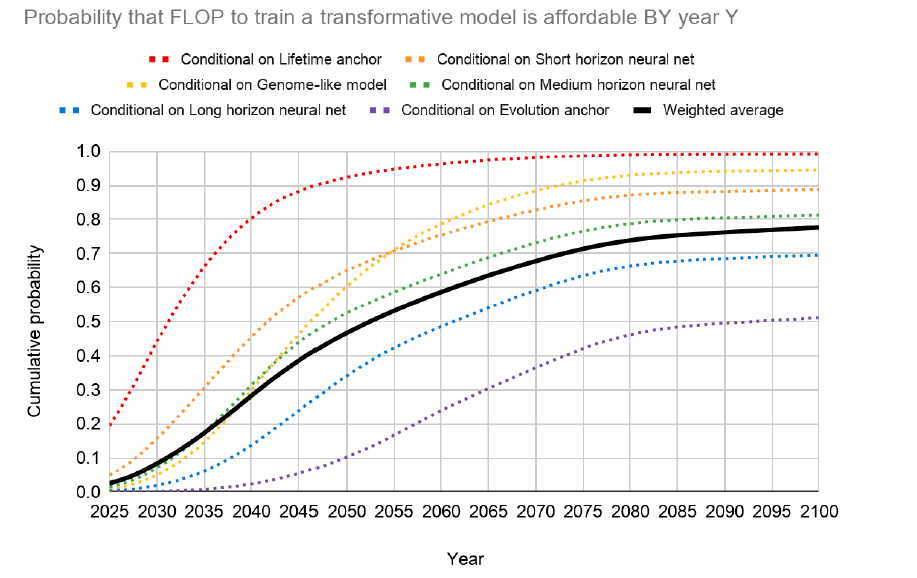

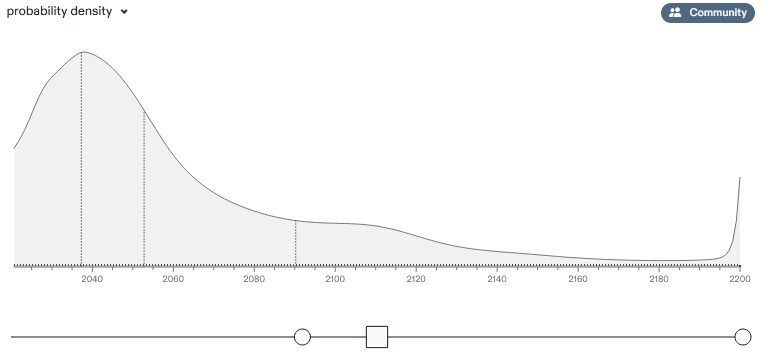

O Relatório Cotra fornece uma longa distribuição de datas (Fig.9) com base nos pesos atribuídos a seis modelos diferentes, cada um com intervalos de confiança muito amplos e opções para se ajustar a média e a variância com base nas suposições alinhadas durante os quatro documentos. A curva preta representa as probabilidades geradas pela combinação ponderada das hipóteses; as curvas coloridas correspondem ao que seria a probabilidade se condicionássemos uma hipótese particular. É possível perceber que a probabilidade cumulativa é de 10% por volta de 2031, 50% por volta de 2052 e quase 80% em 2100 (curva preta na Fig.9).

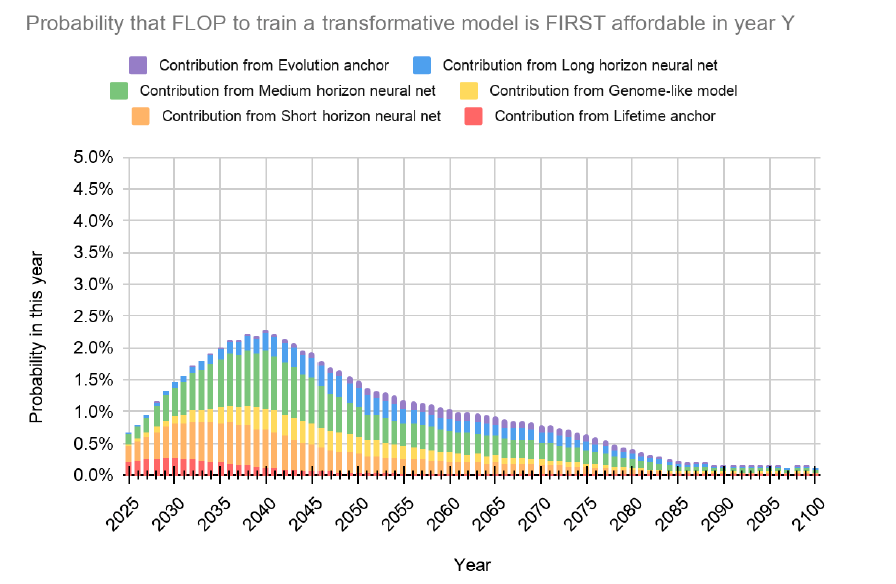

Na Fig. 10, a distribuição cumulativa acima foi convertida em uma distribuição que descreve a probabilidade de que a computação necessária para se treinar um modelo transformativo, se torne acessível em um ano específico (os anos foram definidos com um espaçamento de 5 anos contados a partir de 2025). A contribuição de cada hipótese para a probabilidade total naquele ano também é mostrada.

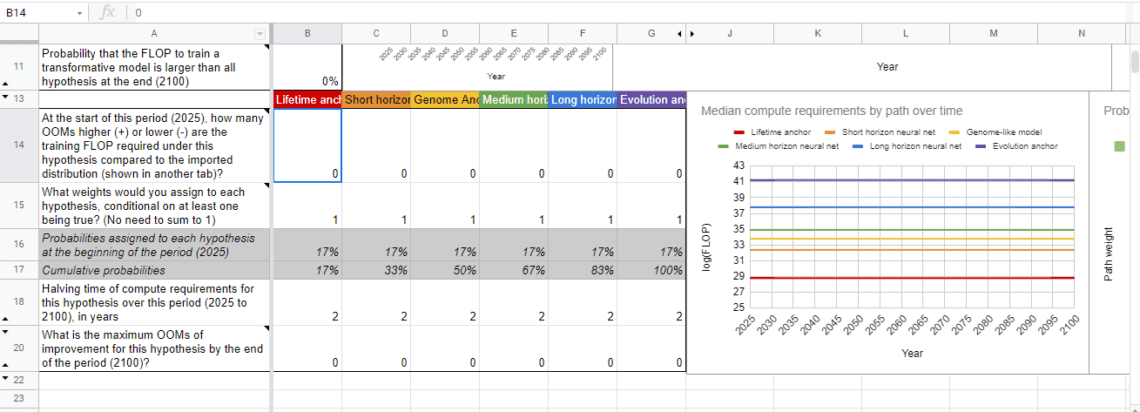

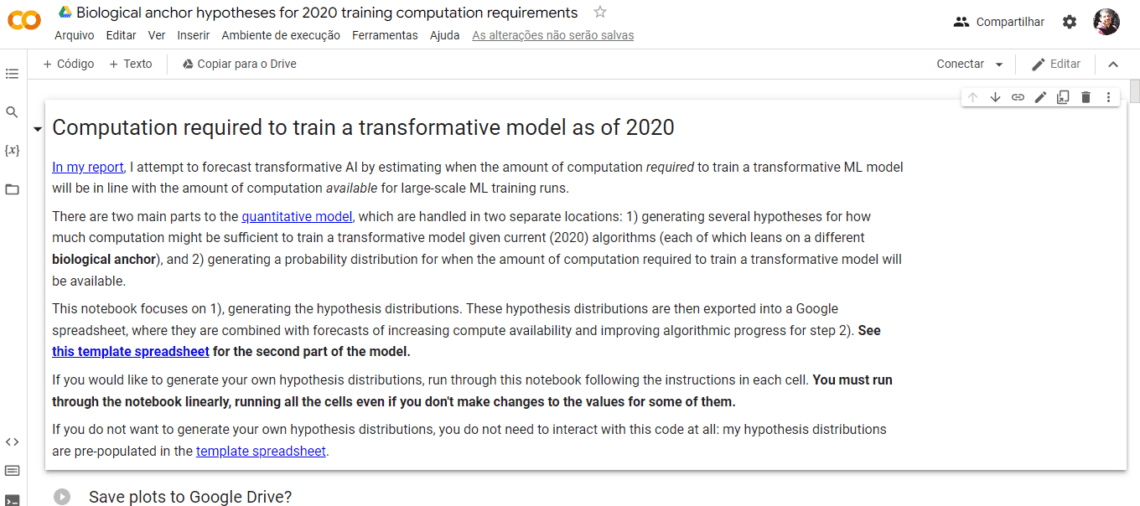

Ajeya atenciosamente concedeu acesso a um Colab notebook e a uma planilha Google spreadsheet para que cada um de vocês possa “brincar” com os modelos preditivos. O notebook permite alterar alguns dos parâmetros mais detalhados dos modelos individuais, e a planilha permite alterar o quadro geral. Creio que muitos possam ter mais familiaridade com planilhas (Fig.11), neste caso basta mudar os parâmetros (colunas B a G) das linhas 14, 15, 18 e 20. No caso do Colab notebook (Fig.12), é preciso rodar o código alterado por você. Para tal, basta ler as instruções (em inglês) deixadas pela Ajeya, alterar os locais indicados e clicar no pequeno ícone de play, que está no início da célula, à sua esquerda.

Para finalizarmos, o quanto do que você leu neste texto é crível na sua opinião?

Quem tiver a oportunidade de ler as 170 páginas do relatório, pode ficar com a impressão de que a Ajeya tomou várias liberdades e fez muitas concessões aos seus pressupostos, usando várias ordens de grandeza e suposições simplificadoras. A amplitude do intervalo das estimativas da hipótese abrange dezessete ordens de magnitude diferentes: o limite superior (10⁴¹) é cerca de cem quatrilhões de vezes o limite inferior (10²⁴). Mas, é sempre bom ter em mente que quando se está construindo algo que nunca existiu, é preciso definir pontos de partida. Pressupostos servem a este propósito.

O que me chamou a atenção no relatório foi que, quatro dos seis modelos, apontam datas dentro de vinte anos a partir de 2050. Os anos a partir de 2050 são recorrentes em previsões a respeito da primeira AGI. O site de previsão de mercado Metaculus , por exemplo, traz uma distribuição muito parecida com a da Ajeya. Tem até a mesma mediana, 2052 (Fig.13), embora não possamos descartar a possibilidade dos analistas do site terem lido o Relatório Cotra.

Deixando de lado essas especulações de mercado, um estudo publicado por Grace et al. [7], onde 352 especialistas de IA foram consultados, encontrou como mediana estimada o ano de 2062 para o surgimento de uma IA que poderia “superar os humanos em todas as tarefas” (embora com ressalvas e alta sensibilidade ao enquadramento de perguntas). Como o estudo foi publicado em 2018, antes do Relatório Cotra (2020), é possível afirmar que eles, definitivamente, não o leram.

O que posso dizer, é que, apesar de aplicar métodos diferentes, Ajeya converge para a mesma estimativa de outros que se propuseram a fazer essa previsão: mais ou menos uma década ou duas a partir de 2050 para a primeira IA de nível humano aparecer. É literatura Grey, sim. Mas, creio que está distante de ser ficção científica.

Referências

[1] Carlsmith, Joe. (2020). “How Much Computational Power Does It Take to Match the Human Brain?” Open Philanthropy, august 14, https://www.openphilanthropy.org/brain-computation-report.

[2] Romero, Alberto. (2021). “Meet M6 — 10 Trillion Parameters at 1% GPT-3’s Energy Cost”. Medium, november 2021, https://towardsdatascience.com/meet-m6-10-trillion-parameters-at-1-gpt-3s-energy-cost-997092cbe5e8.

[3] Hernandez, Danny; Brown, Tom B. (2020). “Measuring the Algorithmic Efficiency of Neural Networks”. arXiv:2005.04305 [cs, stat], may 2020. arXiv.org, http://arxiv.org/abs/2005.04305.

[4] Jeffries, Scott. (2022). “How Much Money Is In The World Right Now?” GOBankingRates, february 2022, https://www.gobankingrates.com/money/economy/how-much-money-is-in-the-world/.

[5] Cross, Tim. (2020). “The cost of training machines is becoming a problem”. The Economist, june 2020. The Economist, https://www.economist.com/technology-quarterly/2020/06/11/the-cost-of-training-machines-is-becoming-a-problem.

[6] Singer, Natasha; (2019). “The Hard Part of Computer Science? Getting Into Class”. The New York Times, january 24. NYTimes.com, https://www.nytimes.com/2019/01/24/technology/computer-science-courses-college.html.

[7] Grace, Katja; Salvatier, John; Dafoe, Allan; Zhang, Baobao; Evans, Owain. (2018). “When Will AI Exceed Human Performance? Evidence from AI Experts”. arXiv:1705.08807 [cs], may 2018. arXiv.org, http://arxiv.org/abs/1705.08807.