Os 8 maiores dilemas éticos da Inteligência Artificial. Sabe quais são?

Os dilemas éticos da Inteligência Artificial precisam ser discutidos. Listamos aqui os 8 maiores e suas implicações para o futuro da humanidade.

Índice do conteúdo

- O que é ética na Inteligência Artificial?

- Dilema 1: Viés algorítmico

- Dilema 2: Privacidade e vigilância

- Dilema 3: Autonomia e responsabilidade

- Dilema 4: Transparência e explicabilidade

- Dilema 5: Discriminação e exclusão social

- Dilema 6: Impacto no mercado de trabalho

- Dilema 7: Uso para fins militares

- Dilema 8: Possibilidade de controle e dominação

Como estamos todos ouvindo ad nauseum por aí, os avanços na inteligência artificial (IA) prometem revolucionar o mundo em diversas áreas, como saúde, educação, segurança e transporte. No entanto, é importante considerar a encrenca que vem de brinde: os dilemas éticos da Inteligência Artificial que surgem com a utilização dessa tecnologia. O desenvolvimento da IA exige uma reflexão sobre os valores morais que devem nortear a sua criação, uso e controle. Neste artigo, apresentaremos os oito maiores dilemas éticos da inteligência artificial.

O que é ética na Inteligência Artificial?

Os dilemas éticos da Inteligência Artificial é uma discussão sobre os valores que devem orientar a criação, uso e controle dessas tecnologias. A IA pode trazer muitos benefícios para a sociedade, mas também pode gerar problemas éticos e morais se não for desenvolvida com responsabilidade. Ou seja, não é apenas uma questão de avaliar a IA em sí, mas principalmente os humanos anexados à ela, seja na área de programação, seja na área governamental. Algumas questões a serem consideradas incluem a justiça, a privacidade, a transparência, a responsabilidade, a autonomia e a segurança.

Dilema 1: Viés algorítmico

Os algoritmos de inteligência artificial podem reproduzir preconceitos e discriminações existentes na sociedade, principalmente quando são treinados com bases de dados que contêm esses vieses. Esse tipo de viés pode gerar decisões injustas e desiguais, o que é preocupante sobretudo em áreas como a justiça e o recrutamento. É preciso desenvolver técnicas para evitar ou minimizar o viés algorítmico.

EXEMPLO:

Quando um algoritmo de reconhecimento facial é treinado apenas em imagens de pessoas brancas, resultando em erros de identificação para pessoas de outras etnias.

Esse viés pode levar a discriminação e exclusão de pessoas de diferentes raças e etnias.

Dilema 2: Privacidade e vigilância

A inteligência artificial pode ser usada para coletar e processar dados pessoais de forma massiva, o que pode levar a uma invasão de privacidade. A vigilância excessiva também pode gerar um ambiente de controle e opressão, sobretudo em regimes autoritários. É importante estabelecer regras claras sobre o uso de dados pessoais e a vigilância por parte dos sistemas de IA.

EXEMPLO:

Uso de câmeras de vigilância com reconhecimento facial em locais públicos.

Embora essas tecnologias possam ajudar a prevenir crimes e aumentar a segurança, elas também levantam preocupações sobre a privacidade dos cidadãos e a possibilidade de uso indevido dos dados coletados. Além disso, o reconhecimento facial pode ser impreciso, levando a falsas acusações e detenções injustas. Nesse caso, é necessário considerar os benefícios e riscos envolvidos e encontrar soluções que garantam a segurança pública sem comprometer a privacidade e os direitos individuais.

Dilema 3: Autonomia e responsabilidade

Quando os sistemas de inteligência artificial são autônomos, ou seja, tomam decisões sem intervenção humana, surge a questão da responsabilidade por essas decisões. Quem é responsável por um acidente causado por um carro autônomo, por exemplo? É preciso estabelecer critérios claros para a atribuição de responsabilidade em casos envolvendo sistemas autônomos.

EXEMPLO:

Uso de carros autônomos.

Se um carro autônomo causar um acidente que resulte em danos pessoais ou morte, quem é responsável: o proprietário do carro, o desenvolvedor de software ou o fabricante do carro? Além disso, se o carro autônomo tiver que tomar uma decisão difícil, como evitar um pedestre ou evitar bater em outro veículo, como essa decisão será tomada e quem será responsável por ela? Essas são questões complexas que exigem uma abordagem ética cuidadosa por parte dos desenvolvedores de tecnologia.

Dilema 4: Transparência e explicabilidade

Os sistemas de inteligência artificial podem ser complexos e difíceis de entender, o que pode gerar desconfiança e incerteza por parte dos usuários. A transparência e a explicabilidade dos sistemas são fundamentais para garantir a confiança e a aceitação da tecnologia. É preciso desenvolver formas de tornar os sistemas mais compreensíveis e explicáveis.

EXEMPLO:

Imagine que uma empresa utiliza um algoritmo de machine learning para tomar decisões de crédito, como conceder empréstimos ou não para determinadas pessoas.

No entanto, os clientes que são negados um empréstimo não recebem uma explicação clara e detalhada sobre como o algoritmo tomou essa decisão. Isso pode gerar desconfiança e até mesmo discriminação por parte dos clientes que não sabem o motivo da recusa. Por outro lado, se a empresa divulgar todos os parâmetros e critérios usados pelo algoritmo, isso pode facilitar fraudes e manipulações por parte dos clientes que procuram enganar o sistema, além de fornecer informações sensíveis sobre o processo de tomada de decisão da empresa. Nesse caso, a empresa enfrenta um dilema ético de IA: como equilibrar a necessidade de transparência e explicabilidade com a proteção da privacidade e segurança dos dados, garantindo a justiça e equalidade na tomada de decisões?

Dilema 5: Discriminação e exclusão social

A inteligência artificial pode gerar exclusão social se não for utilizada de forma justa e equitativa. Alguns grupos podem ser discriminados ou deixados de lado pela tecnologia, o que pode agravar desigualdades existentes na sociedade. É importante garantir que a IA seja usada de forma inclusiva e sem discriminação.

EXEMPLO:

Uso de algoritmos de seleção de candidatos para empregos.

Se esses algoritmos forem treinados com dados históricos de contratação, que já refletem a discriminação e exclusão de determinados grupos sociais, como mulheres, pessoas de cor, LGBTQ+, pessoas com deficiência, entre outros, os algoritmos podem perpetuar esses padrões de exclusão e discriminação.

Por outro lado, se os algoritmos forem ajustados para dar prioridade aos candidatos que vêm de grupos historicamente excluídos e marginalizados, isso poderia resultar em uma discriminação inversa contra candidatos que não pertencem a esses grupos. Além disso, a definição de grupos historicamente excluídos pode ser complexa e contestável, o que torna o ajuste dos algoritmos uma tarefa delicada. Assim, o dilema ético está em como equilibrar a necessidade de corrigir as desigualdades históricas e de promover a diversidade e inclusão, com a necessidade de evitar a discriminação e exclusão de candidatos que não pertencem a grupos beneficiados pelos ajustes dos algoritmos.

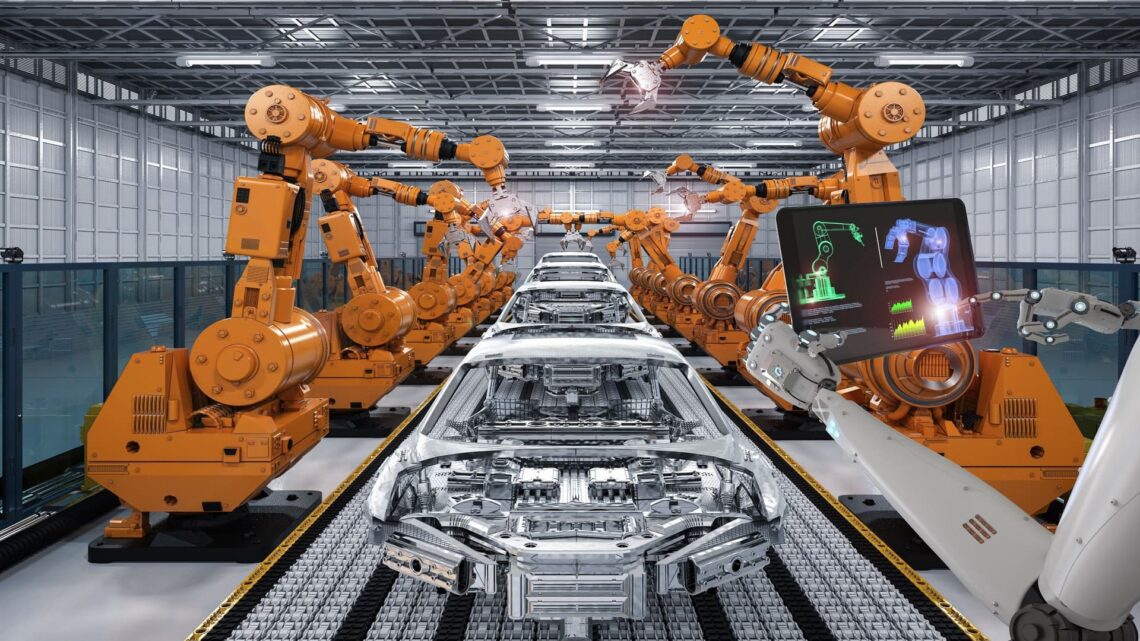

Dilema 6: Impacto no mercado de trabalho

A inteligência artificial pode substituir empregos que antes eram realizados por seres humanos, o que pode gerar desemprego e desigualdade. É preciso pensar em formas de garantir que o desenvolvimento da IA não prejudique os trabalhadores e que haja uma transição justa para novos modelos de trabalho.

EXEMPLO:

Uso de robôs autônomos em fábricas.

Embora esses robôs possam aumentar a eficiência e produtividade, eles também podem substituir trabalhadores humanos, resultando na perda de empregos. Por um lado, a implementação de robôs autônomos pode levar a uma redução significativa nos custos de produção, permitindo que as empresas ofereçam preços mais competitivos e aumentem suas margens de lucro. Por outro lado, o aumento do desemprego pode levar a uma desigualdade econômica ainda maior, resultando em problemas sociais e políticos. Os desenvolvedores de IA enfrentam o dilema ético de equilibrar os benefícios potenciais de suas tecnologias com as consequências negativas para os trabalhadores e a sociedade em geral. Eles devem considerar não apenas os benefícios econômicos a curto prazo, mas também as implicações sociais e políticas a longo prazo de sua tecnologia.

Dilema 7: Uso para fins militares

A inteligência artificial pode ser usada para fins militares, o que pode gerar riscos para a segurança global e violações de direitos humanos. É importante discutir os limites éticos para o uso da IA em contextos militares, bem como formas de garantir o controle e a transparência dessas tecnologias.

EXEMPLO:

Uso de drones autônomos para ataques aéreos.

Embora os drones autônomos possam ser programados para atingir alvos com precisão e minimizar danos colaterais, eles podem tomar decisões sem a supervisão humana e, portanto, podem cometer erros ou causar danos desnecessários. Além disso, o uso de drones autônomos pode reduzir a responsabilidade dos militares e aumentar a probabilidade de conflitos armados, já que o uso de máquinas pode parecer menos grave do que o uso de pessoal militar. Portanto, a decisão de usar ou não drones autônomos para ataques aéreos pode ser vista como um dilema ético de IA.

Dilema 8: Possibilidade de controle e dominação

A inteligência artificial pode ser usada para fins de controle e dominação, sobretudo em regimes autoritários. É importante considerar os riscos de uso indevido da IA e estabelecer normas que garantam o controle democrático e a liberdade individual.

EXEMPLO:

Utilização de IA em sistemas de vigilância e segurança com o objetivo de prevenir crimes, mas que acabam sendo usados para vigiar e controlar cidadãos de forma excessiva e invasiva.

Esse cenário coloca em questão a privacidade e liberdade individual, bem como o papel da tecnologia na manutenção da ordem social. Além disso, há o risco de que esses sistemas sejam usados para discriminar grupos específicos de pessoas com base em características como raça, gênero ou religião, o que pode levar a uma maior desigualdade e injustiça. Nesse caso, o dilema ético envolve equilibrar a segurança pública e a proteção dos direitos e liberdades individuais, e garantir que a IA seja usada de forma ética e responsável.

É fundamental discutir e enfrentar os dilemas éticos da inteligência artificial, para garantir que essa tecnologia seja usada de forma responsável e inclusiva. A ética na IA deve ser uma preocupação constante de todos aqueles que trabalham com essa tecnologia, bem como de governos, empresas e sociedade em geral. A reflexão sobre os valores que devem orientar a IA é fundamental para garantir um futuro mais justo e humano.