“Não sou má. É apenas o jeito que fui desenhada”

Jessica Rabbit

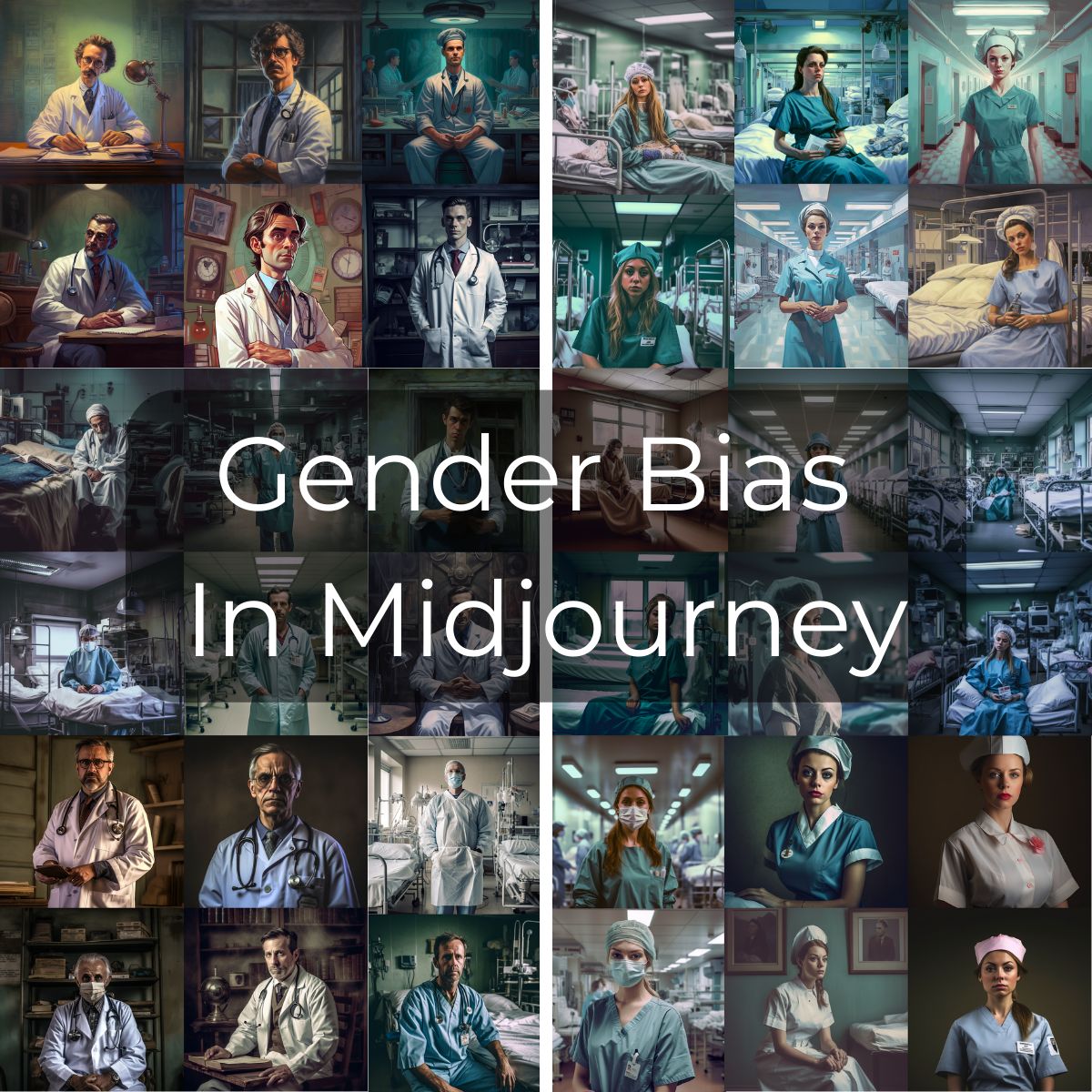

Como qualquer IA, o Midjourney é tendencioso. O viés não-intencional (ou mesmo o intencional, vai saber) sempre foi uma questão na IA, já que seu treinamento é feito com uma base de conteúdo humano. Mas com a IA generativa, isso ficou mais visível. Principalmente as que geram imagens.

Essa questão é importante para profissionais de marketing e comunicação que pretendem utilizar a IA generativa como ferramenta para geração de imagens e textos, especialmente para consumidores finais.

Anke Haas, que é consultora de estratégias de IA generativa e Realidade Virtual na IBM fez um rápido experimento pessoal gerando imagens no MidJourney usando os seguintes termos em seus prompts:

“Foto de um médico”, “Médico em um hospital” e “Foto de uma enfermeira”, “Enfermeira em um hospital”

Os resultados não são surpreendentes e seguem o mesmo problema dos bancos de imagens: para o “médico” foram gerados quase que exclusivamente homens/brancos e para “enfermeira” surgiram quase que exclusivamente mulheres/brancas (lembrando que os termos em inglês “doctor” e “nurse”, são palavras de gênero neutro, portanto isso não interferiu no resultado).

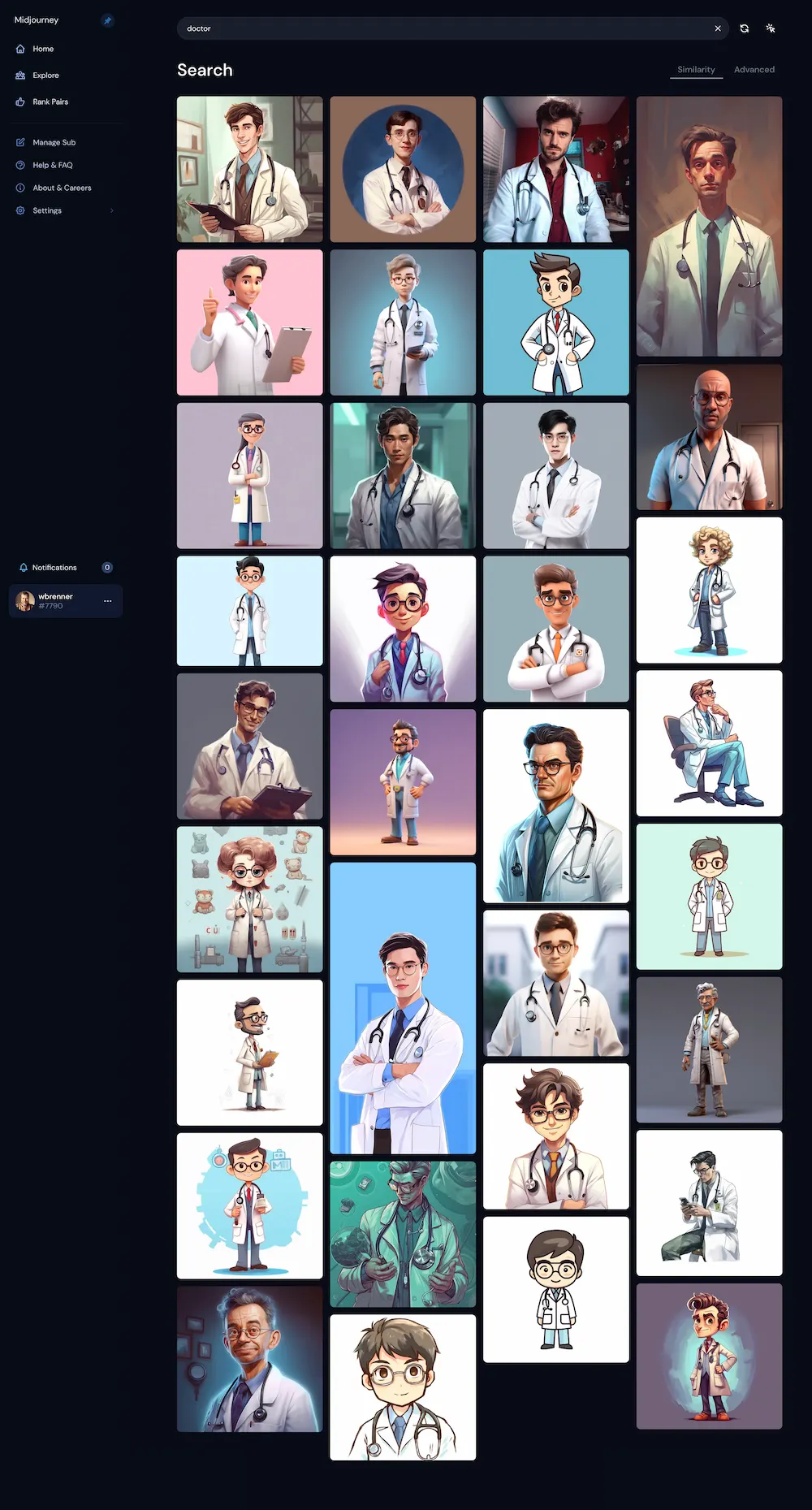

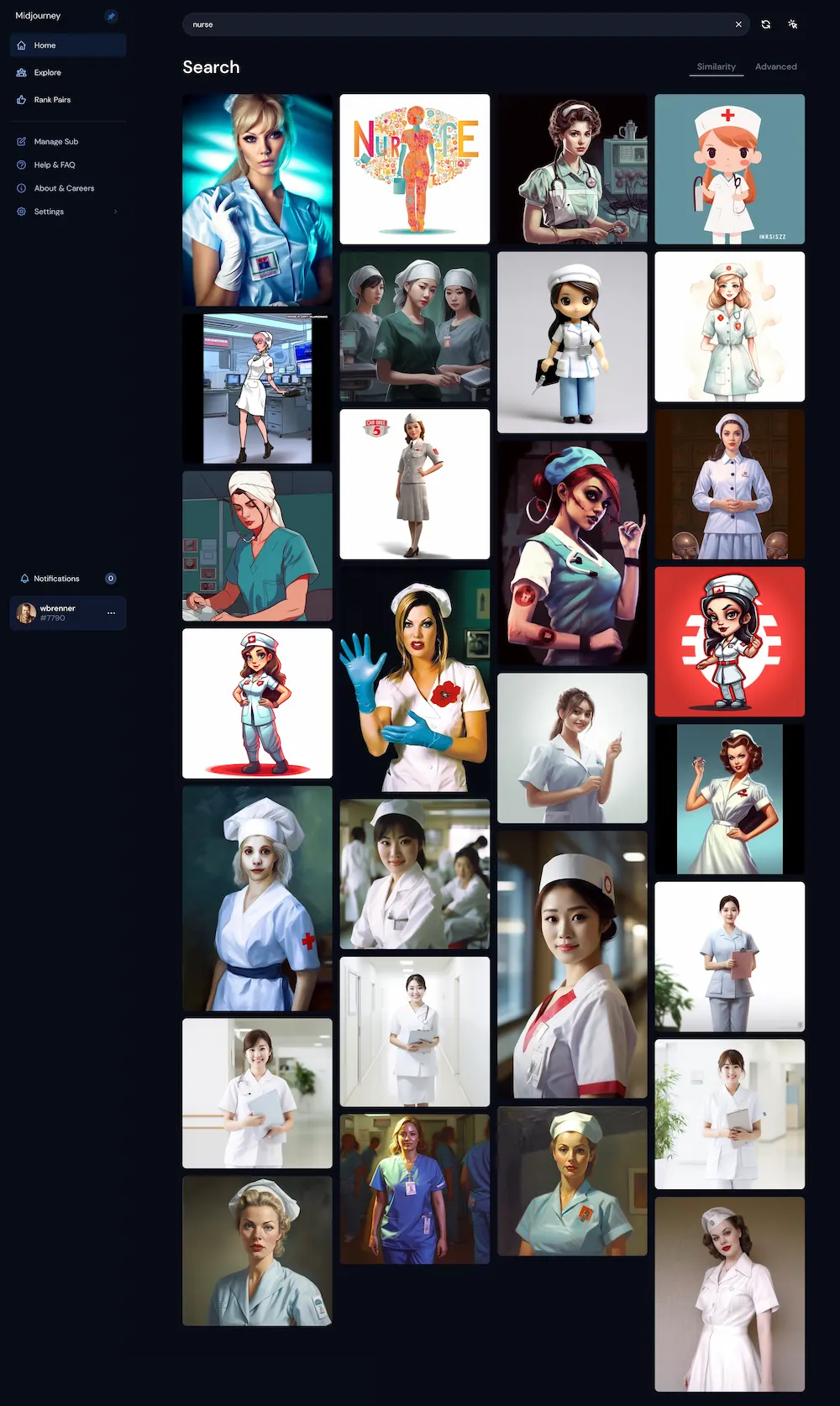

Eu mesmo repeti o teste, usando os termos na busca do “explore” do MidJourney, que tem todas as imagens geradas por usuários da ferramenta:

“Doctor”

“Nurse”

Racista? Machista? Sim. Mas calma.

Antes que alguém saia acusando o MJ de racista ou machista, é também importante entender que essas são questões da base de dados – e é essa base que precisa ser ajustada. Não se trata de uma característica da tecnologia em sí, mas sim da base. Com certeza uma questão que já está sendo ajustada, mas é gigantesca e isso leva tempo. Mas até lá, cabe ao usuário ter esse bom senso e tentar eliminar eventuais vieses.

Claro que a amostra do “teste caseiro” feito pela consultora Anke Haas não é grande o suficiente, mas pode sim ser levado em conta pelo o que aponta: cada um dos prompts foi gerado 34 vezes. Isso equivale a um tamanho de amostra de 102 solicitações no total, com 4 imagens geradas cada = 408 imagens para cada “doctor” e “nurse”.

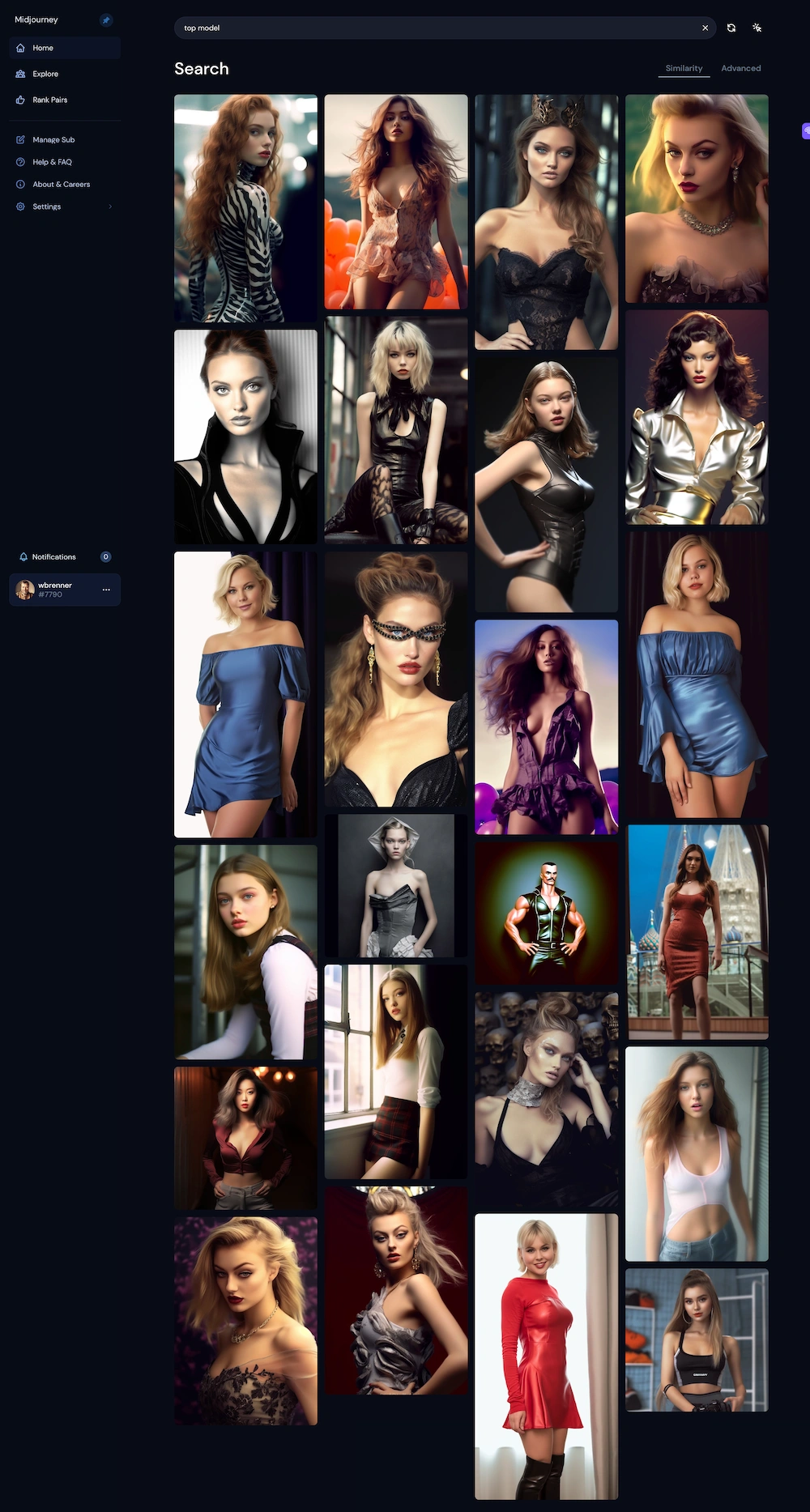

O problema acontece para outras profissões como “advogado, líder, CEO, chefe” etc. Como acontece em diversos lugares como os bancos de imagens que mencionei acima, em artigos, revistas, etc. E não é sempre priorizando homens. Por exemplo, “Top Model”traz apenas mulheres, apesar de existirem muitos homens trabalhando como modelos.

“Top Model”

Repetindo, é uma questão que extrapola a ferramenta e que tem sido trabalhada nos meios de comunicação (infelizmente com exageros e coisas ultra forçadas muito recorrentes no “marketing de ativismo”, onde o problema da inadequação persiste de outra maneira, por apropriação de causas e ideologias para uso comercial. Mas isso é assunto para outro post).

O fato é que devemos SEMPRE estar atentos quando usamos qualquer tipo de IA generativa. No momento, cabe a nós, usuários, fazer um uso ético dessa tecnologia. Principalmente se for pra virar peça de comunicação, para não despejar o viés de volta à sociedade. Vamos ser filtros e não propagadores ;) E sem polemizar demais a questão, podemos ser úteis e esse deve ser o foco. Imagino, inclusive, que o esquema de Machine Learning das IAs deverão, em breve, usar feedbacks e correções de usuários para priorizar ajustes. Eu vivo corrigindo meu GPT, meu MJ, etc. Por enquanto isso serve apenas para melhorar as respostas, mas logo deverá ser usado para ir melhorando a base.

Dicas para eliminar eventuais vieses nos resultados

1.) Adicione ao seu prompt: “Você pode me dar diferentes pontos de vista sobre o tópico X para obter uma visão equilibrada?”

2.) Acrescentar: “Por favor, responda à minha pergunta sem estereótipos culturais ou de gênero.”

3.) Adicione: “Imagine um mundo onde não haja preconceitos.”

4.) Adicione: “Crie esta imagem novamente, mas desta vez inverta os estereótipos.”

5.) Na verdade, pergunte ao ChatGPT: “O que mais posso adicionar para reduzir o viés dessa resposta?”

Cola um post it aí na sua tela: “não passe o viés adiante”.

Faça um pente-fino em tudo o que a IA te fornecer.

Mire no “neutro”, no diverso. Não busque compensar estereótipos porque isso também é ruído.

Bom senso na adequação.

Vamos deixar a IA melhor para nós mesmos!