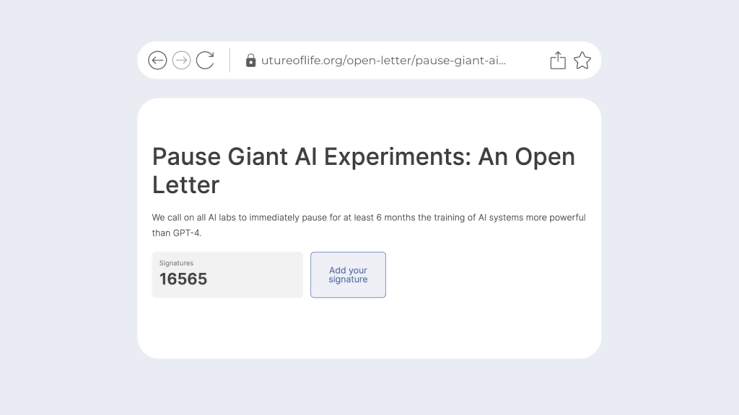

Penso que a maioria deve se lembrar da carta, assinada por milhares de acadêmicos e executivos de tecnologia, pedindo uma “pausa” de 6 meses na pesquisa e desenvolvimento de Inteligência Artificial (IA). Pois é, já faz 6 meses. Fui lembrado essa manhã pelo Gary Marcus, um dos que assinaram a carta. Eu também assinei, mas confesso que me arrependi pouco tempo depois.

Embora as razões do meu arrependimento sejam mais do que confessáveis (percebi que era mais uma estratégia dos que estavam atrás nas pesquisas do que uma preocupação genuína), não vem ao caso explorar essa linha argumentativa neste texto. Gary me listou em um e-mail o que ele considera que mudou e o que não mudou depois da moratória. E isso é mais interessante do que minhas reclamações.

Bom, para começar vale dizer que Gary também se arrependeu de ter assinado. No caso dele, a razão está mais ligada ao fato da carta ter sido repetidamente politizada e mal interpretada. Ele foi acusado de tentar exagerar o perigo da IA (o que não era sua intenção), além de algumas más interpretações de que a carta pedia a proibição de todas as pesquisas sobre IA (que não era o que ela pedia e não é algo que ambos apoiariam).

A verdade é que pouca gente parou com as pesquisas. A única que sabemos foi a OpenAI, que colocou uma pausa no desenvolvimento do GPT-5. Sam Altman, CEO da OpenAi, declarou no seu testemunho ao senado norte-americano em maio (como pode-se ler pelas transcrições AQUI):

Sam Altman

“No momento não estamos treinando o que será o GPT-5. Não temos planos de fazer isso nos próximos seis meses.”

Não sabemos o motivo real da parada, mas Sam foi mais um dos que assinaram a carta. Gary acha que entre o lançamento do GPT-4 em novembro de 2022 e o testemunho de maio de 2023, a OpenAI realizou alguns testes preliminares e decidiu que o sistema não atenderia às expectativas. Como as estimativas do custo de modelagem do GPT-4 bateram a casa do US$1 bilhão [1], creio que a pausa poupou pelo menos alguns milhões de dólares em energia elétrica no desenvolvimento do GPT-5.

Obviamente nunca haverá uma verdadeira moratória no curto prazo. A economia da IA é sedutora demais para muitos: para quem cria empresas de IA, para quem investe em empresas de IA, para quem trabalha nessas empresas e recebe salários de 6 ou 7 dígitos e para quem espera doações de campanha de grandes empresas de tecnologia.

Mas ainda há muito com o que se preocupar com cada vez mais IA sendo produzida. Deixo aqui três que me tiram o sono: desinformação (tanto intencional quanto acidental), crime cibernético e malware, e armas biológicas geradas por IA. O primeiro ponto já é uma realidade, diga-se de passagem que não apenas por culpa da IA, embora seu uso aumente exponencialmente o que já enfrentamos hoje. O segundo, é uma realidade para muitos. Por exemplo, devo sofrer umas três tentativas de invasão por semana. A Google inclusive migrou minha pasta de modelos para um servidor físico nos Estados Unidos para melhor “proteger” os arquivos, o que me causa uma preocupação adicional (e que me levou a fazer um backup físico em HD externo caso haja dúvidas no futuro de quem é o “dono” da propriedade intelectual). O terceiro ponto não é uma realidade ainda, mas creio que não demora a ser.

Mas vamos à lista do Gary (comentários meus em parênteses):

O que mudou

Hoje se dá muito mais atenção às políticas de IA do que no início do ano. A carta de pausa definitivamente tem crédito nisso (não sabemos ao certo o quanto). Governos de todo o mundo intensificaram a realização de audiências públicas e reuniões na tentativa de descobrir o que se deve fazer em relação à IA.

O campo continuou a fazer avanços. O DALL-E 3 parece genuinamente interessante; a nova versão do Bard (Google), de acordo com o New York Times [2], foi melhorada, embora ainda se comporte de maneira errática.

A ONU começou a levar a sério uma política global de IA, constituindo um órgão consultivo de alto nível a pedido do Secretário-Geral Guterres [3].

Algumas iniciativas nos EUA da Casa Branca (criação de diretrizes voluntárias) e do Congresso americano para o desenvolvimento de um processo de licenciamento de IA similar ao feito pelo FDA com medicamentos (aliás, muito parecido com o relatório da Pew Research de 2021 sobre como o FDA já regula produtos médicos baseados em IA [4]) foram colocadas na mesa.

O que não mudou

A política em torno da IA ainda é em grande parte fictícia e irreal. Diretrizes voluntárias não são leis e nem mecanismos de aplicação; as empresas ainda podem fazer o que quiserem.

Grandes modelos de linguagem (LLMs) continuam no mesmo estágio de não confiança. Ainda inventam coisas (“alucinam”) e seu raciocínio lógico é menos racionalista do que se imagina. É preciso não levar ao pé da letra o que diz o ChatGPT e fazer um esforço cognitivo adicional para analisar suas respostas em termos de relevância, utilidade e confiabilidade (submeti ontem um paper a um journal científico exatamente sobre esse assunto).

Como sociedade, ainda não temos qualquer plano sobre o que podemos fazer para mitigar os riscos a longo prazo. A IA atual é bastante estúpida em muitos aspectos, mas o que faríamos se uma IA superinteligente realmente fosse iminente e representasse algum tipo de ameaça genuína (por exemplo, uma nova forma de ataque com armas biológicas – como indiquei alguns parágrafos acima)? Ainda dispomos de muita pouca ferramenta para vigiar ou enfrentar tais ameaças.

As Big Techs prometeram transparência, mas a verdade é que nenhuma delas nos dirá realmente o que está nos seus conjuntos de dados (as diretrizes voluntárias não abordam isso). E se não soubermos o que está nos conjuntos de dados, não poderemos saber que vieses ou preconceitos esses sistemas irão espalhar pela sociedade se forem amplamente utilizados. Qualquer esforço externo para mitigar riscos são enormemente prejudicados (por exemplo, não podemos avaliar adequadamente a capacidade de generalização desses sistemas sem compreender a relação entre seus dados de treinamento e seus resultados). Sem isso, enfrentar os riscos é como tentar secar uma pilha de pratos com uma única toalha encharcada de água.

A minha opinião é que a carta pedindo moratória foi uma primeira iniciativa válida. Não creio que o tema alinhamento de IA teria ganho a mídia tradicional se não fosse por ela. É claro que a assinatura de personalidades, como Elon Musk, foi o grande chamariz. Mas, não creio que o foco principal tenha sido atingido. Como dizia a própria carta [5], uma IA mais avançada pode representar uma mudança profunda na história da vida do nosso planeta. Deveria ser planejada e gerida com recursos e cuidados proporcionais.

REFERÊNCIAS

[1] Edelman, Yafah. “Report on Frontier Model Training”. www.lesswrong.com, https://www.lesswrong.com/posts/nXcHe7t4rqHMjhzau/report-on-frontier-model-training.

[2] Roose, Kevin. “Google’s Bard Just Got More Powerful. It’s Still Erratic.” The New York Times, 20 de setembro de 2023. NYTimes.com, https://www.nytimes.com/2023/09/20/technology/google-bard-extensions.html.

[3] UN. Artificial Intelligence | Office of the Secretary-General’s Envoy on Technology. https://www.un.org/techenvoy/content/artificial-intelligence.

[4] Pew Research. “How FDA Regulates Artificial Intelligence in Medical Products”. 5 de agosto de 2021, https://pew.org/3yglbCS.

[5] Future of Life Institute. “Pause Giant AI Experiments: An Open Letter”. The Future of Life Institute, https://futureoflife.org/open-letter/pause-giant-ai-experiments/. Acessado 22 de setembro de 2023.